mardi, 28 novembre 2017

« Intelligence artificielle » : périls (déjà) en la demeure ?

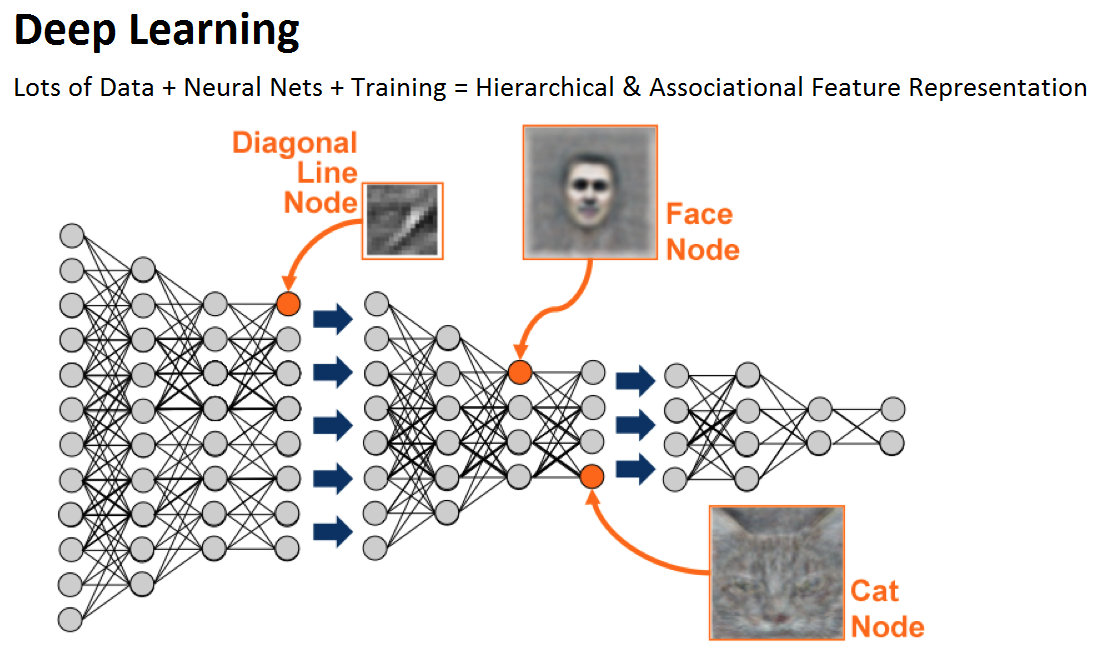

Samedi dernier la docteure Marie-Claude Goulet publiait dans le journal Le Devoir un article intitulé « Les menaces technicistes de l’intelligence artificielle ». En s’inspirant du livre « Cerveau augmenté, homme diminué ? » du philosophe et clinicien Miguel Benasayag, elle soulevait certaines questions sur la place de plus en plus grande qu’occupe dans nos sociétés ce qu’on appelle « l’intelligence artificielle ». Cette longue tradition de recherche en informatique a connu depuis quelques années des avancées importantes grâce aux techniques de l’apprentissage profond (« deep learning », en anglais).

Pour le dire très vite, on parle ici de machines dont la structure est inspirée de notre cerveau (des réseaux de neurones, mais ici virtuels) et qui sont capables d’apprendre suite à des entraînements répétés au lieu d’être programmés par des humains. La reconnaissance vocale sur votre téléphone, la reconnaissance visuelle des visages sur Facebook ou les améliorations récentes sur Google translate en sont des exemples qui nous facilitent la vie au quotidien. Mais ces technologies ne pourraient-elles pas également nous nuire ? Autrement dit sont-elles toujours au service de la vie, de la culture et de l’esprit critique ou ne nous asserviraient-elles pas plus qu’elles nous libèrent, demande Goulet en reprenant les préoccupations de Benasayag.

Il y a de nombreux enjeux importants soulevés dans cet article, et je voudrais seulement en évoquer quelques-uns en fournissant des liens vers d’autres ressources pertinentes pour approfondir ces questions.

Un point important amené par Benasayag est cette idée que les êtres humains, contrairement aux technologies de l’intelligence artificielle, possèdent un corps avec une histoire de vie (et même une longue histoire évolutive). Elle rejoint tout-à-fait le courant de l’approche incarnée en sciences cognitives où d’autres avant lui, comme Francisco Varela et Evan Thompson, ont défendu l’idée que c’est par ce corps que l’on doit garder vivant que nous vient la signification des choses. Simplement bonnes ou mauvaises dans un premier temps, et par la suite en d’infinis raffinements avec les émotions, les sentiments, l’esthétique, l’éthique, etc.

L’intelligence artificielle actuelle, on l’a dit, a connu beaucoup de succès depuis qu’elle imite le cerveau humain et sa structure connexionniste. Mais elle ne cherche pas (du moins pas encore…) à imiter le corps entier avec son histoire incarnée propre à chacun. C’est en partie pour cette raison que ses domaines d’application restent spécifiques et que ces technologies n’ont pas la flexibilité et les capacités de généralisation et d’adaptation de l’intelligence humaine.

Et donc effectivement, pour reprendre les mots de Benasayag, « Une machine sans limite thésaurise de l’information, tandis qu’un corps avec des limites produit un monde de sens. » Voilà pour une distinction de base qui permet d’éviter certaines craintes par rapport aux « intelligences artificielles » actuelles qui découlent souvent d’une méconnaissance de cette différence fondamentale entre les machines et nous.

Mais tout n’est pas si simple, bien entendu… L’interaction entre les outils que les humains fabriquent depuis ses origines ont de tout temps influencé son cerveau, et donc ses façons de réfléchir et de penser le monde qui l’entoure. Pareil pour la culture dans laquelle il naît et qui va sculpter littéralement son cerveau, l’amenant à avoir une vision du monde, une cosmologie, semblable à celle de ses pairs. Ce qui, il faut bien l’admettre, est bien pratique pour se comprendre au sein d’un groupe (et qui est donc forcément très adaptatif). Ce n’est donc pas d’hier que pour être plus efficaces lorsqu’on calcule on utilise un crayon, un boulier, une calculatrice ou un ordinateur. Même chose pour l’écriture. Les moines copistes auraient-ils été les mêmes s’ils avaient disposé de dactylos ? Les monastères auraient en tout cas été pas mal plus bruyants… ;-P

Le phénomène n’est donc pas nouveau et l’on n’assiste pas, avec les téléphones intelligents par exemple, à un changement qualitatif par rapport à ce phénomène que des philosophes étudient depuis longtemps sous des vocables comme « coévolution gène – culture » ou encore « cognition étendue ». Mais au niveau quantitatif, en termes de puissance que ces « applications » ajoutent à notre cognition et au niveau de la vitesse avec laquelle elles se développent, là il y a quelque chose d’assez unique qui est en train de se produire. Faut-il pour autant s’en effrayer ?

Là encore, cela dépend de ce qu’on l’on fait avec ces nouveaux outils. Bien sûr, on peut faire une critique de ces innovations technologiques en termes de priorités globales pour l’espèce humaine alors que, comme l’évoque Marie-Claude Goulet, « plus du tiers de l’humanité ne comble pas ses besoins minimaux en nourriture. ». Ou alors questionner aussi comme elle le fait l’exemple des maisons intelligentes souvent donné par le chercheur en apprentissage profond de l’Université de Montréal Yoshua Bengio. Mais critiquer la pertinence d’appareils faisant jouer une musique à notre goût ou tamisant l’éclairage au moment opportun dans notre maison, c’est un peu comme critiquer le thermostat qui garde une température constante dans la même maison : celle des technologies qui nous procurent plus de confort (et encore une fois, bien sûr, on pourrait se demander si ce type de technologie qui pousse encore plus loin notre confort devrait se développer avant que la planète entière ait un confort minimal…).

Du reste, s’il faut parler de Joshua Bengio, il est l’un des rares chercheurs de pointe dans son domaine à avoir refusé les offres des Facebook et Google et qui prend le temps d’expliquer la nature de ses travaux et ses implications sociales. Il s’entoure pour ce faire de philosophes et d’éthicien.nes qui participent à des événement comme le récent Forum sur le développement socialement responsable de l’intelligence artificielle qui s’est tenu à l’Université de Montréal.

Et parmi ces questions éthiques « qui tuent » (au sens figuré comme au sens propre) figurent celles qui découlent du système de production capitaliste dans lequel se développent inévitablement ces technologies. Et comment elles peuvent être utilisées par des compagnies pour réduire à la longue des citoyen.nes à de simples consommateurs bien conditionnés. Ou par des États guerriers pour réduire les mêmes citoyen.nes vivants dans des pays « ennemis » en simples miettes (quand la reconnaissance faciale se met au service des drones militaires, par exemple…).

Mais il y a un péril, peut-être moins spectaculaire que ces technologies militaires mais non moins préoccupants parce que plus insidieux et apparemment inoffensif. Il s’agit d’appareils qui rivalisent d’astuces pour s’accaparer ce bien précieux qu’est votre attention (votre « temps de cerveau disponible », pour rappeler cette fâcheuse expression). Cette guerre en est une de basse intensité mais elle se produit à tous les jours grâce à nous chers téléphones, tablettes et portables sur lesquels nous parcourons nos chers réseaux sociaux. Bref, à chaque fois qu’on descend un peu notre fil de nouvelle Facebook pour voir si on a des « likes ». Exactement comme le rat qui appuie sur un levier et s’aperçoit qu’il obtient ainsi une boulette de nourriture va avoir le goût de répéter la chose. Ou comme les addicts des machines à sous le font dans les casinos.

Car le terme d’addiction, on le sait, n’est pas trop fort ici, comme l’explique Paul Lewis dans un excellent reportage intitulé : « ‘Our minds can be hijacked’: the tech insiders who fear a smartphone dystopia”. Du type qui a eu l’idée du « Like » dans Facebook à un autre qui a développé chez Apple ce qu’on appelle les « push-notification technology » qui vous avertissent contiunellement du moindre événement, ces gens avouent avoir développé ces gadgets sans en avoir compris sur le coup les conséquences. Et celles-ci peuvent se résumer grosso-modo à la victoire de l’impulsion sur l’intention, du sensationnel sur le nuancé, bref du bottom up sur le top down. Autrement dit, c’est Trump dans toute sa splendeur…

Et j’aimerais en terminant vous signaler un podcast fort éclairant sur cette question. Il s’agit d’un entretien entre le philosophe et neurobiologiste Sam Harris et David Krakauer, président du Complex Systems à l’Institut Santa Fe. L’une des distinctions les plus utiles que fait Krakauer est celle entre les artéfacts cognitifs qu’il appelle complémentaires par opposition à ceux qu’il qualifie de compétitifs.

Dans le premier cas, l’artéfact ne nous aide pas seulement pour ce qu’il a été conçu, mais nous fait développer des compétences que l’on peut par la suite généraliser dans d’autres domaines. Il prend l’exemple de la bonne vieille fourchette qui nous permet de manger plus facilement mais qui, indirectement, développe une dextérité manuelle qui peut nous être utile dans d’autres domaines. Même chose pour les gens qui apprennent le calcul avec un boulier : on sait maintenant qu’il favorise aussi des compétences linguistiques et en géométrie.

Mais il y a ces autres artéfacts, ou algorithmes d’intelligence artificielle, que Krakauer qualifie de compétitifs parce qu’ils remplacent, et bien souvent réduisent, le champ des possible de l’esprit humain. On pense ici à Netflix ou Amazon qui vous suggère des films ou des livres que des gens comme vous ont vu ou on lu. Ou à l’espèce de bulle rassurante dans laquelle les médias sociaux nous confinent en nous montrant de préférence les gens qui, selon ce qu’ils publient, pensent en quelque sorte comme nous. Il y a ici, comme le dit, Krakauer, une contraction des possibilités cognitives qui est préoccupantes. Sans parler des dangers pour la diversité d’opinions et la liberté d’expression.

Je vous laisse avec la chute de l’article de Lewis qui est tellement à propos ici aussi : “Will we be able to recognise it, if and when it happens?” Williams replies. “And if we can’t, then how do we know it hasn’t happened already?”

Au coeur de la mémoire | Comments Closed